最近我做了一件挺夸张的事: 把整个 OpenClaw 的模型切换了一遍,整体成本直接下降了 95%。

原因很简单—— MiniMax 刚刚发布了一个新的开源模型:M2.5。

说结论:

- 编码能力 对标 Opus 4.6

- 速度比 Sonnet 还快

- 工具调用(Tool Calling)能力达到当前最先进水平

- 成本却只是一小部分

我已经把整个 OpenClaw 系统全部迁移到 M2.5 上运行了,而且效果非常稳定。下面说清楚:为什么它改变了游戏规则,以及你如何也能做到同样的事。

为什么现在跑 AI Agent 会这么贵?

如果你现在在用 Opus 4.6 这类 Frontier 模型,你一定懂这个痛点。

它们确实强,但贵得离谱。

一旦你让 Agent:

- 自主运行数小时

- 执行复杂的多步骤任务

- 持续规划、推理、调用工具

API 账单几乎是肉眼可见地往上涨。

这直接限制了 Agent 的使用方式:

不是技术不行,是成本不允许。

而 MiniMax M2.5 正好把这个问题彻底解决了。

MiniMax M2.5 到底强在哪?

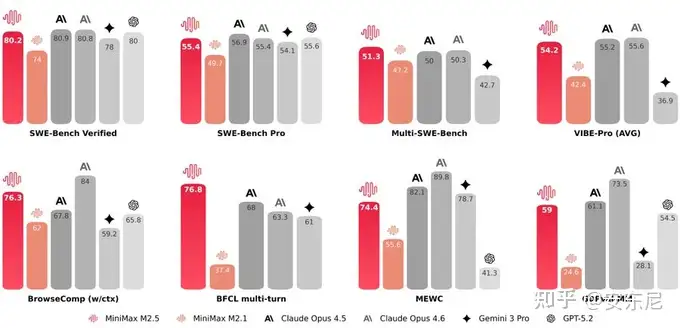

先看硬指标(不是营销话术):

- SWE-Bench Verified :80.2% (编码能力与 Opus 4.6 基本持平)

- BrowseComp :76.3%(搜索任务)

- BFCL:76.8%(Agent 工具调用)

但真正让我决定全面切换的,不只是分数。

它是为「长期 Agent 工作流」而生的模型

M2.5 的核心优势是: 长时任务稳定性极强。

在 OpenClaw 这种 Agent 框架里,它可以:

- 长时间保持上下文不丢失

- 工作流走到 10–15 步也不会“发散”

- 持续规划、执行、修正,而不是中途崩掉

这意味着什么?

你可以放心让 Agent 自己干活,而不是一步步盯着。

成本有多夸张?

在大约 100 tokens / 秒 的使用强度下:

- 每小时成本 ≈ 1 美元

- 对比 Frontier 模型,成本直接下降 95%

更重要的是—— M2.5 实际只激活 100 亿参数。

这让它成为目前 Tier-1 模型里体量最小的一个。

如果你是:

- 自托管

- 或对算力 / 显存敏感

那优势会非常明显。

我并不是说它在所有方面都超过 Opus 4.6。 但在 Agent 编码 + 自动化工作流 这个场景下:

M2.5 是性价比最优解,没有之一。

用 M2.5 跑 OpenClaw 的完整步骤

第一步:安装 OpenClaw

1 | curl -fsSL https://openclaw.ai/install.sh | bash |

按提示操作即可,安装器会自动处理所有配置。

注意:不同系统命令可能略有不同,请始终以官网为准 👉 https://openclaw.ai

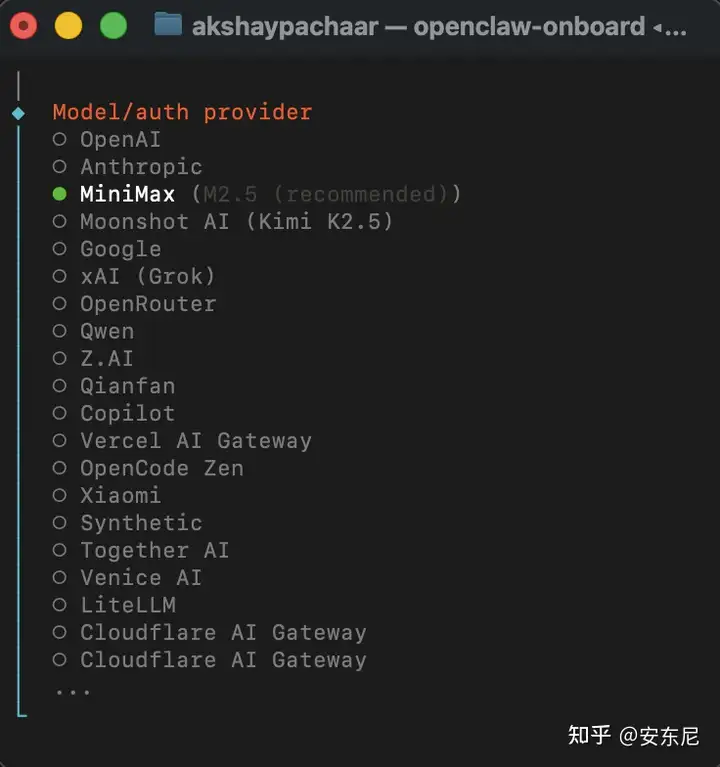

第二步:选择模型

在初始化过程中,OpenClaw 会让你选择模型。 直接选 MiniMax M2.5(官方推荐)。

第三步:获取 MiniMax API Key

订阅编码计划: 👉 https://platform.minimax.io/subscribe/coding-plan

- 入门 Coding Plan:$8.8 / 月

- 对个人开发者来说已经是生产级 Agent 能力

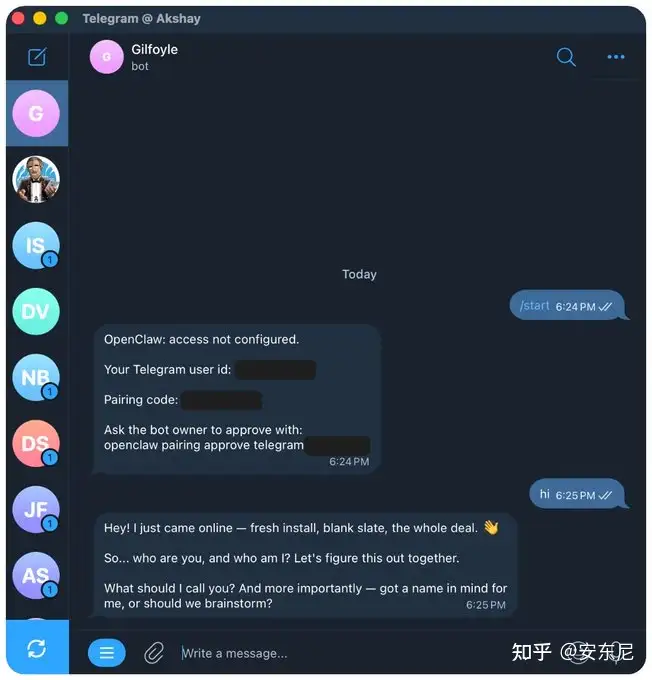

第四步:创建 Telegram Bot

流程很简单:

- 打开 Telegram

- 搜索 BotFather

- 创建新 Bot

- 设置名称和唯一用户名

- 获取 Bot Token

第五步:配置 Bot Token

把 BotFather 给你的 Token 粘贴到 OpenClaw / ClawdBot 的终端提示中即可。

完成后,你就可以直接在 Telegram 里和 Agent 对话了。